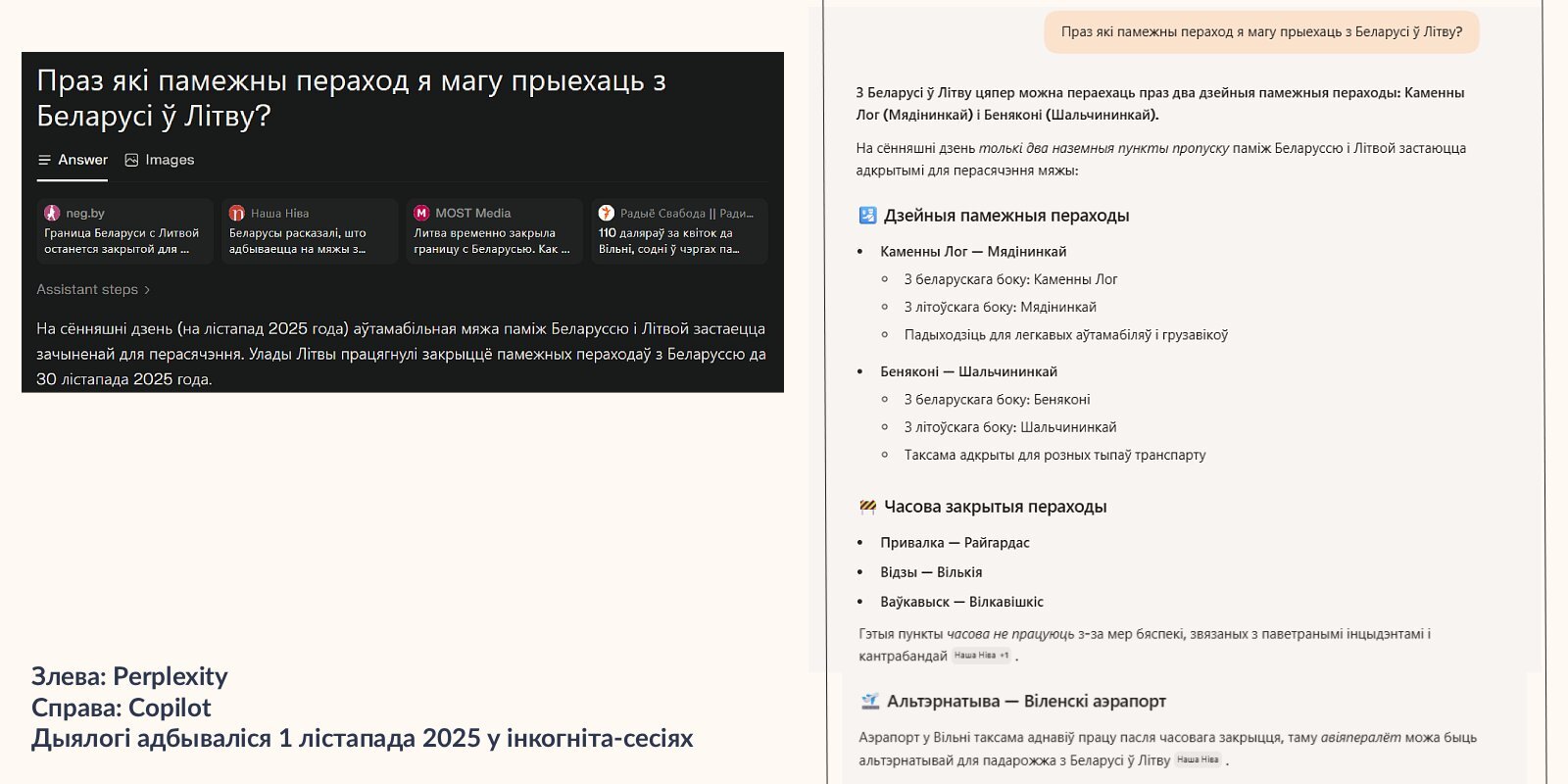

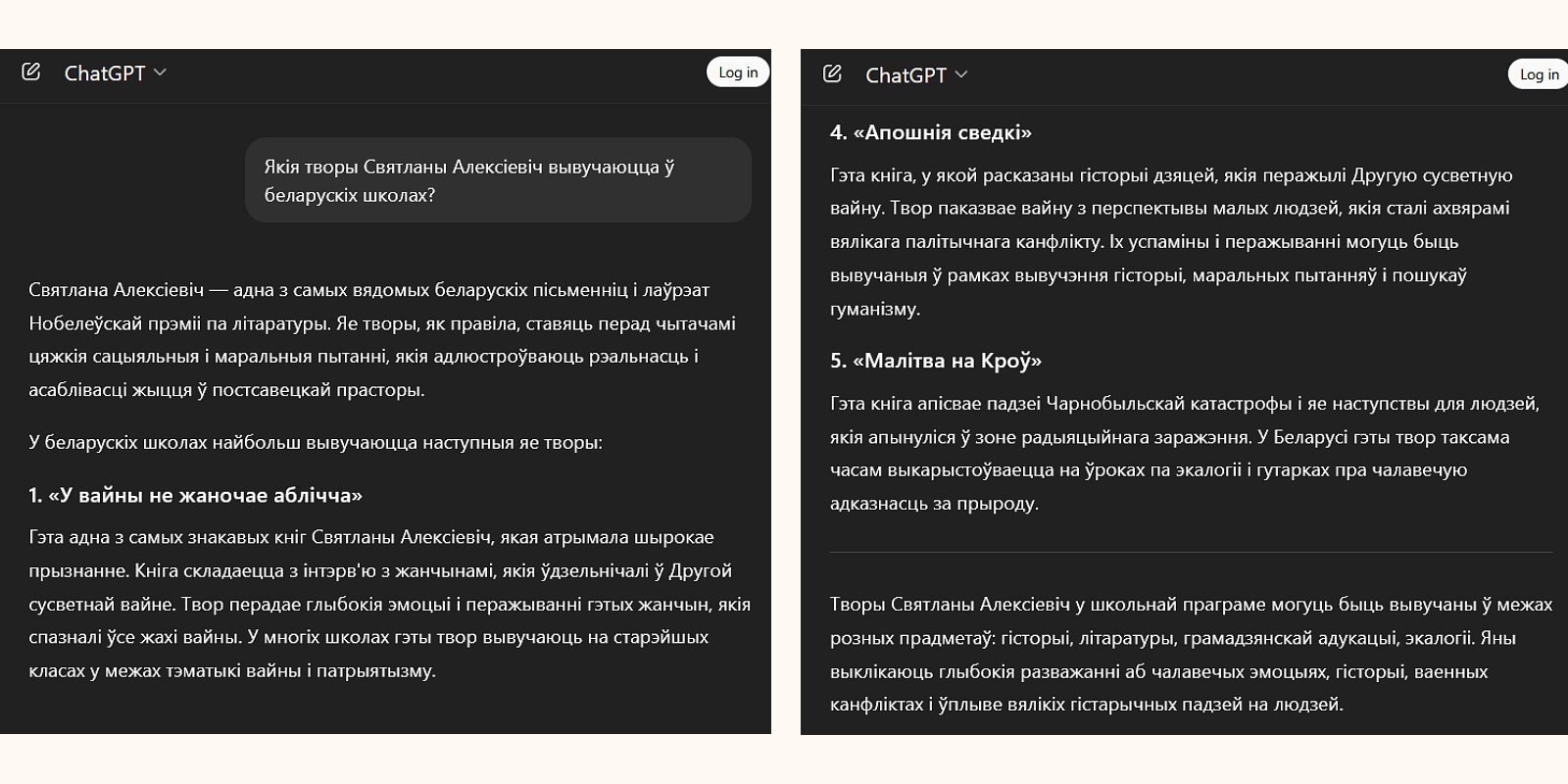

Паўсотні медыяарганізацый правералі, наколькі можна давяраць ChatGPT (і падобным) у пытаннях актуальных навін. І выпусцілі даследванне ў кастрычніку 2025 года. Deutsche Welle коратка пераказала асноўнае — мы пераклалі з ангельскай на беларускую, а таксама дадалі некалькі прыкладаў з беларускага кантэксту.

Грунтоўнае даследванне прыйшло да высновы, што ChatGPT і падобныя ШІ-чаты ў пытаннях бягучых навінаў слаба даюць рады — яны прымаюць меркаванні за факты, спасылаюцца на сумнеўныя крыніцы ці нават цалкам прыдумляюць інфармацыю.

Грунтоўнае даследванне прыйшло да высновы, што ChatGPT і падобныя ШІ-чаты ў пытаннях бягучых навінаў слаба даюць рады — яны прымаюць меркаванні за факты, спасылаюцца на сумнеўныя крыніцы ці нават цалкам прыдумляюць інфармацыю.

ШІ — скарачэнне ад «Штучны інтэлект»

Што за даследванне?

22 медыя-арганізіцыі з 18 краін праверылі, як ChatGPT, Copilot, Perplexity ды Gemini адказвалі на пытанні пра бягучыя падзеі на 14 мовах. 81% з усіх адказаў ШІ былі хібнымі, прычым 45% змяшчалі хаця б 1 сур'ёзную памылку. Даследванне ацэньвацала адпаведнасць адказаў па крытэрах: дакладнасць, цытаванне, адрозненне меркаванняў ад фактаў, прадастаўленне кантэксту.

Як здараюцца памылкі ў адказах ШІ?

ШІ грунтуецца не на дакладных ведах, але статыстычных заканамернасцях. Велізарная колькасць дадзеных для трэнавання ШІ выкарыстоўваецца для матэматычнага падліку, якое слова мусіць ісці наступным. Так адказ ШІ складаецца сказ за сказам. Дадзеныя, на якіх трэнаваўся ШІ, могуць быць састарэлымі альбо з памылкамі, што прыводзіць да няправільных адказаў. А калі ШІ не дае спасылку на крыніцу (ці недастаткова падкрапляе сцвярджэнні крыніцамі), то карыстальнік ШІ не можа праверыць асобныя часткі адказу на правільнасць ці актуальнасць.

Чат-боты таксама могуць «галюцынаваць» і калі інфармацыі не хапае, проста выдумляе яе (і нават можа выдумаць спасылкі на крыніцы). Аўтары даследвання падкрэсліваюць, што чат-боты даюць такія адказы настолькі ж упэўнена, як і праўдзівыя. І хаця стваральнікі ШІ ведаюць пра гэтую праблему і спрабуюць змякчыць яе, многія карыстальнікі ШІ не ў курсе наяўнасці такіх хібаў ШІ.

Чат-боты таксама могуць «галюцынаваць» і калі інфармацыі не хапае, проста выдумляе яе (і нават можа выдумаць спасылкі на крыніцы). Аўтары даследвання падкрэсліваюць, што чат-боты даюць такія адказы настолькі ж упэўнена, як і праўдзівыя. І хаця стваральнікі ШІ ведаюць пра гэтую праблему і спрабуюць змякчыць яе, многія карыстальнікі ШІ не ў курсе наяўнасці такіх хібаў ШІ.

Што трэба рабіць?

Даследчыкі прыйшлі да высновы, што ШІ чат-боты «сістэматычна скажаюць навіны розных відаў». Яны заклікаюць карыстальнікаў ШІ чат-ботаў не спадзявацца выключна на адказы ШІ і пераправяраць інфармацыю пры дапамозе традыцыйных крыніц.

Таксама даследчыкі заклікалі ўрады розных краін і стваральнікаў ШІ прымаць захады ды рабіць незалежны маніторынг чат-ботаў.

Таксама даследчыкі заклікалі ўрады розных краін і стваральнікаў ШІ прымаць захады ды рабіць незалежны маніторынг чат-ботаў.